Fertigungsunternehmen erzeugen mit ihren IoT-, Cloud- und Machine-Learning-Strategien immer mehr strukturierte und unstrukturierte Daten. Viele Unternehmen setzen dabei auf die Datenspeicherung in Data Lakes, an denen sich die Datenkonsumenten bedienen können. Der damit einhergehende Prozess der manuellen Daten-Replizierung, -Transformierung und -analyse kostet jedoch Ressourcen, die vielleicht an anderer Stelle sinnvoller eingesetzt werden könnten.

Mehr als Daten speichern

Zudem reicht die Datenspeicherung alleine für viele IoT-Anwendungen nicht aus. Wenn Firmen für spezielle Applikationen die Datenverarbeitung nahezu in Echtzeit benötigen, kommt Event-Streaming ins Spiel. Dabei handelt es sich um Event- oder Ereignis-basierte Datenverarbeitung, wodurch viele Daten laufend verarbeitet, analysiert und an verschiedenen Stellen bereitgestellt werden: kontextbasiert, in großem Maßstab und in Fast-Echtzeit. Als Standard für diese Datenverarbeitung hat sich mittlerweile Apache Kafka als Software etabliert. Es verbindet die Vorteile von Messaging-Systemen sowie Batch-basierter Extract/Transform/Load-Lösungen (ETL), die in den meisten Fällen entweder bis zu einem geringen Grad skalierbar oder schlichtweg nicht schnell genug sind.

Plattformen schlagen Brücke

Auf dem Weg zur Industrie 4.0 ermöglichen eine flächendeckende Machine-to-Machine-Kommunikation sowie die Verschmelzung von Informationstechnologie (IT) und operationeller Technologie (OT) die Vernetzung der Produktionsumgebung. Dies schafft die Grundlage für weitere Prozessautomatisierung und das Monitoring von Anlagen. Auch Maschinen, die Systemprobleme eigenständig diagnostizieren und analysieren, werden realisierbar. Event-Streaming-Plattformen können die dabei anfallenden Datenvolumen in Echtzeit verarbeiten, eine Voraussetzung für die meisten dieser Szenarien. Die Plattformen können zudem eine Brücke zwischen modernen und Legacy-Systemen schlagen, ohne die die meisten Fertigungen noch länger nicht auskommen werden. In einer solchen hybriden Architektur, in der Anwendungen Cloud-basiert funktionieren, diese jedoch mit Edge-Systemen kommunizieren oder einen Datenaustausch mit Data Centers zustande bringen müssen, schafft es Event-Streaming, beide Welten zu vernetzen.

Beispiele für den Einsatz

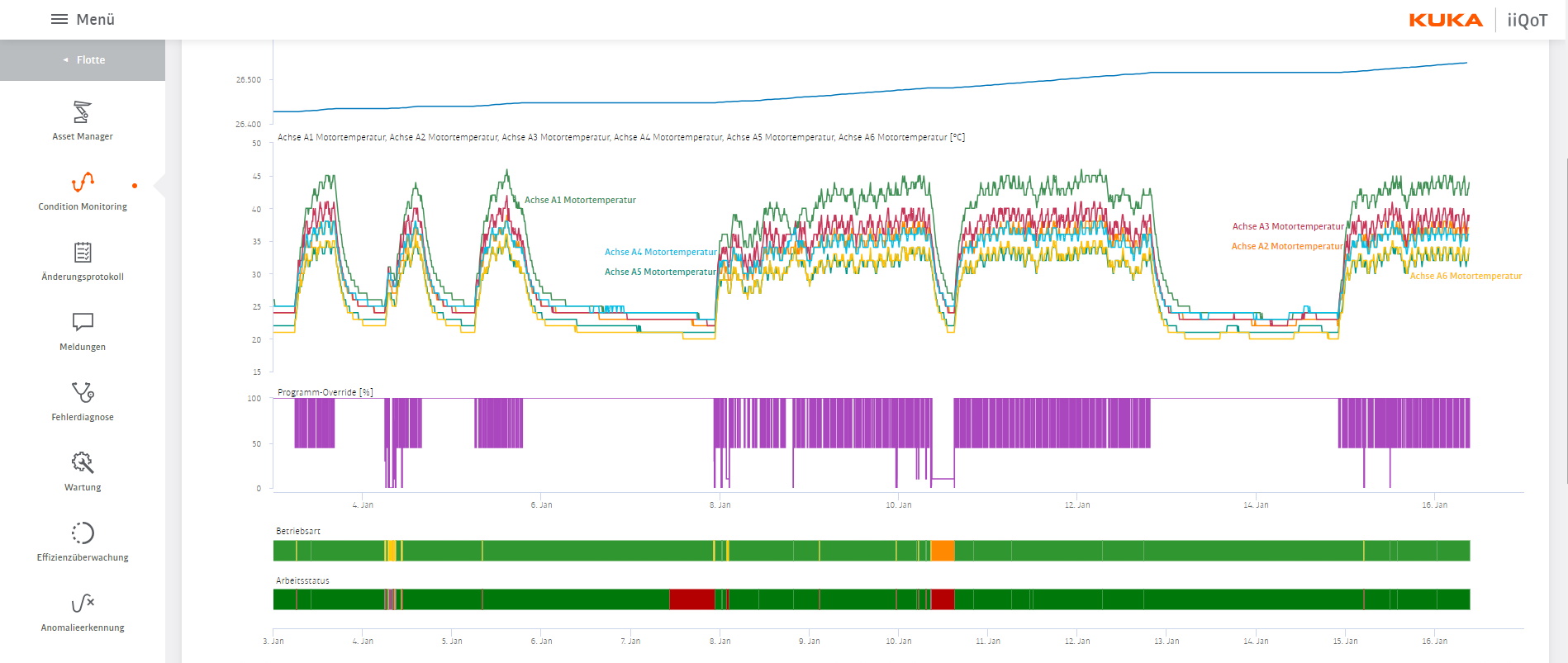

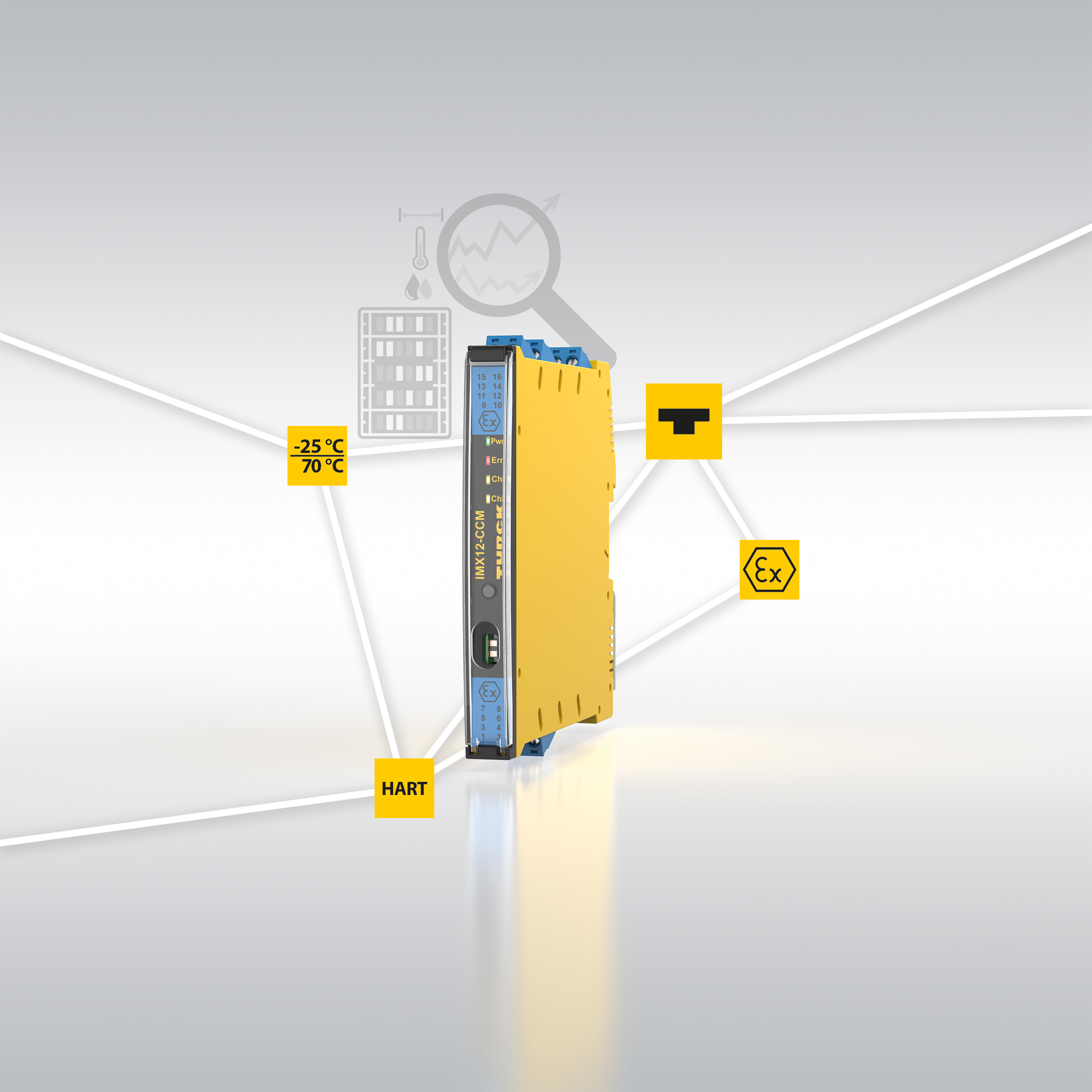

In Produktionsumgebungen lässt sich Event-Streaming auf vielfältige Weise einsetzen. Die Integration mit Enterprise-Ressource-Planning- und Manufacturing-Execution-Systemen (ERP, MES) verschafft Unternehmen einen Überblick über Waren-, Produkt- und Service-Bewegungen innerhalb des Inventars, des Lagerhauses oder über die gesamte Lieferkette hinweg. Das erlaubt eine genauere Planung und Logistik. Außerdem bieten sich Anwendungsfelder an wie Anlagen-Monitoring und Predictive Maintenance. Event-Streaming-Plattformen ermöglichen einen Echtzeit-Blick auf den Ist-Zustand der Geräte. Darüber hinaus ist die Datenverarbeitung schnell genug, um Simulationen im Sinn von digitalen Zwillingen zu ermöglichen, die Aufschluss auf zukünftige Wartungszyklen geben. Dazu müssen die Daten über den Zustand in der aktuellen sowie in der Idealumgebung zusammengeführt werden.

IT-Sicherheit

Die Verschmelzung von IT und OT hat den Nachteil, Hackern womöglich neue Angriffsflächen zu bieten, um in das System einzudringen oder Malware einzuschleusen. Es gilt also, den Datenfluss im Auge zu behalten. Event-Streaming-Plattformen können auch sehr große Datenströme in Echtzeit auf Anomalien analysieren. Das ermöglicht es den IT-Sicherheitsteams im Fall eines Angriffs, schneller mit Gegenmaßnahmen zu reagieren.

Nacheinander einsteigen

Entscheidet sich ein Unternehmen dafür, Event-Streaming zur Datenverarbeitung zu nutzen, spielt der Einsatz der richtigen Technologie eine untergeordnete Rolle. Vielmehr müssen sie sich vorab im Klaren sein, dass auf dieser Reise sämtliche Teams bereichsübergreifend an einem Strang ziehen müssen. Systeme und Datensilos, die bisher getrennt voneinander existierten, werden durch Event-Streaming miteinander verbunden. Bis diese technologie überall im Unternehmen angekommen ist, durchlaufen Firmen meist verschiedene Phasen. Zu Beginn wird Event-Streaming in kleineren Projekten von Seiten des Entwicklerteams ausgerollt, sobald an einzelnen Punkten viele Daten bewegt werden sollen. Mit der Zeit steigt die Zahl der Anwendungsfälle im Unternehmen, wenn andere Teams die Technologie auf ihren Aufgabenbereich adaptiert haben. Nachdem ein Großteil der unternehmenskritischen Bereiche in das Event-Streaming eingestiegen ist, lassen sich die einzelnen Teams und ganze Geschäftsbereiche womöglich zusammenführen und zentralisieren. Solche Schritte sollte ein Change Management begleiten.

Technik alleine reicht nicht

Die Umstellung von getrennten Teams und Datensilos auf eine einheitliche Event-Streaming-Plattform, die sämtliche Unternehmensbereiche abdeckt, ist eine langwierige Reise. Der Einsatz von Technologie reicht nicht, sie wird durch das Etablieren eines darauf abgestimmten Betriebsmodells begünstigt. n Field CTO und Global Technology Advisor bei Confluent.

www.confluent.io