Immer höhere Anforderungen an Produkte und folglich auch an deren Fertigungsprozesse führen im Produktionsumfeld zu einer steigenden Komplexität. Als Folge entstehen oft Wissenslücken hinsichtlich des Zustandes des Produktionssystems. Ein Ansatz, die Wissenslücken zu schließen, liefert Big Data. Big Data kann durch die Analyse und Auswertung großer Datenmengen dabei helfen, Trends und Muster zu erkennen, um beispielsweise Maßnahmen zur Produktqualitätssteigerung abzuleiten. Zudem kann eine Datenanalyse mehr Klarheit hinsichtlich der Arbeitsabläufe schaffen. Ungewissheiten wie die Verfügbarkeit bzw. Leistung von Maschinen können so behoben werden. In den vergangenen Jahren haben neben großen Unternehmen auch KMU das Potenzial großer Datenmengen erkannt. Selbst kleine Unternehmen können mit ihrer Infrastruktur schon heute die Kapazitäten, große Datenmengen zu speichern und somit zumindest die technischen Möglichkeiten, geschäftsrelevante Informationen aus den Daten zu generieren. Allerdings nutzen bislang nur wenige KMU die Vorteile von Big Data. Die größte Herausforderung stellt dabei die fehlende Expertise der Mitarbeiter auf diesem Fachgebiet dar.

Was ist Big Data?

Für den Begriff Big Data existieren in der Literatur mehrere Definitionen. Laut des amerikanischen Marktforschungsunternehmen Gartner z.B. beschreibt Big Data ‚hochvolumige, schnelle und/oder variantenreiche Informationsbestände, die eine kosteneffiziente, innovative Form der Informationsverarbeitung erfordern, die einen verbesserten Einblick, eine Entscheidungsfindung und Prozessautomatisierung ermöglicht‘. In der Literatur wird Big Data oftmals mit Hilfe von drei V’s charakterisiert – Volume, Velocity, Variety. Volume bezieht sich auf die großen Datenmengen, häufig im Bereich von Terrabytes bis Zettabytes. Velocity geht auf die Geschwindigkeit des Datenstroms ein, der durch den Einsatz moderner Software nahezu in Echtzeit analysiert und ausgewertet werden kann. Variety bedeutet, dass die Daten in unterschiedlich strukturierter Form vorliegen (strukturiert, semi-strukturiert und unstrukturiert) und aus einer Vielzahl unterschiedlicher Datenquellen stammen können. Einige Autoren definieren darüber hinaus noch weitere V’s. So bezieht sich Veracity auf die Datenqualität. Durch inkonsistente, unvollständige, mehrdeutige, abhängige oder fehlerbehaftete Daten können Unsicherheiten entstehen. Ein fünftes V steht für Value und beschreibt den potenziellen Vorteil, den Unternehmen aus den Big-Data-Erkenntnissen generieren und zur Steigerung ihres Unternehmenswertes nutzen können.

Zielsetzung von Big-Data-Projekten

Ziel von Big-Data-Projekten ist es, Erkenntnisse aus großen Datenmengen zu gewinnen. Diese großen, teils unstrukturierten Datenmengen erschweren jedoch das Erkennen von Zusammenhängen. Dafür sind eine technische Infrastruktur, Verarbeitungswerkzeuge und Techniken erforderlich, die die Bewältigung des Volumens sowie der Vielfalt in hoher Geschwindigkeit ermöglichen. Bei der Generierung neuer Erkenntnisse kann zwischen vier Datenanalysemethoden unterschieden werden, die sich anhand ihres Mehrwertes und ihrer Komplexität voneinander unterscheiden: deskriptive Anlayse, diagnostische Analyse, prädiktive Analyse und präskriptive Analyse. Big-Data-Analysen sind den beiden letzteren zuzuordnen. Bei der deskriptiven Datenanalyse werden historische Daten betrachtet und sowohl gute als auch schlechte Ergebnisse aufgezeigt. In der diagnostischen Analyse werden zusätzlich Ursachen und Aus- sowie Wechselwirkungen erklärt, Folgen analysiert und Muster identifiziert. Die prädiktive Analyse beinhaltet darüber hinaus Vorhersagen und Prognosefähigkeiten. Bei der präskriptiven Analyse sind Systeme in der Lage, eigene Entscheidungen zu treffen.

Big Data im Produktionsumfeld

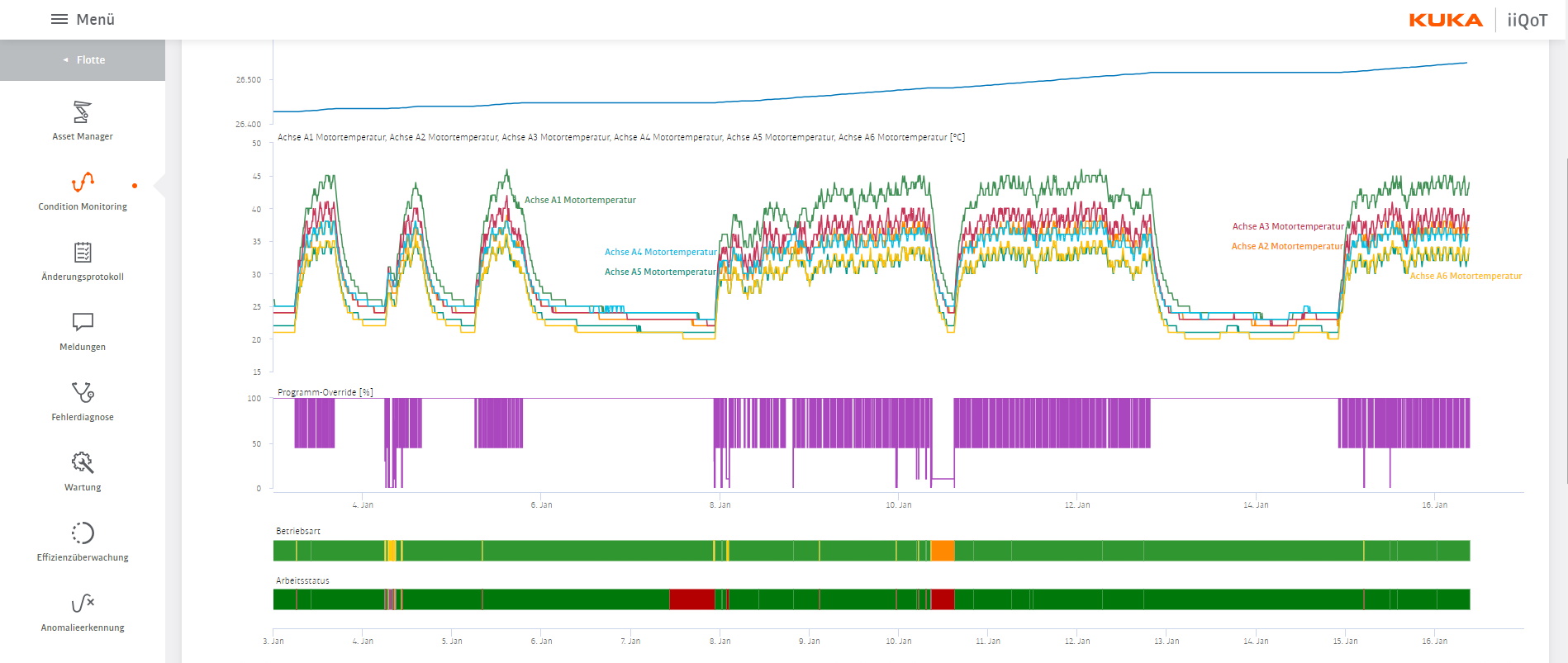

Der Branchenverband Bitkom erwartet, dass das Zusammenspiel von Internet-Technologien und Big-Data-Verfahren in den kommenden Jahren zu deutlichen Produktivitätssteigerungen in der Industrie führen wird. Die Kombination aus preiswerten Sensortechnologien, IT-Infrastrukturen mit hoher Leistung sowie flexiblen und vorausschauenden Analyse- und Planungssystemen verändert das Produktionsumfeld nachhaltig. Das Industrial Internet of Things (IIoT) ermöglicht die Betrachtung von Produktionsprozessen nahezu in Echtzeit durch den Einsatz von Technologien wie 5G. So kann laut Bitkom eine Umgebung zur optimalen Steuerung des Produktionsumfangs, der Materialien und der Energieträger geschaffen werden. Die Nutzung der großen anfallenden Datenmengen kann durch die Implementierung geeigneter Big-Data-Werkzeuge erfolgen, beispielsweise durch effiziente Erfassungs-, Speicher-, Abrufsysteme, Data Mining und proaktive Modelle. Der Einsatz der Werkzeuge ermöglicht deutlich schnellere Recherchen aus dem Datenpool, hilft Optimierungsschritte hinsichtlich Maschineneinstellungen einzuleiten oder lässt Aussagen zu frühzeitigen Wartungsmaßnahmen zu. So kann die Produktherstellung erleichtert, die Produktleistung verbessert und im Idealfall auch die Produktlebensdauer verlängert werden.

Herausforderungen für KMU

KMU werden beim Ersteinsatz von Big Data mit einigen Herausforderungen konfrontiert. Erste große Hürden sind vielfach Bedenken der Geschäftsführung und Mitarbeiter hinsichtlich des Datenschutzes und der Manipulation. Auch muss innerhalb der Belegschaft eine Vertrauensbasis gegenüber den zum Einsatz kommenden Algorithmen geschaffen werden. Vielfach besteht darüber hinaus eine große Unsicherheit hinsichtlich des Aufwand-Nutzenverhältnisses und der Frage, ob die benötigten Kapazitäten und Qualifikationen im Unternehmen vorhanden sind. So fehlen insbesondere KMU oft entsprechende Fachkräfte. Die notwendigen Werkzeuge und Techniken zur Implementierung von Big Data lassen sich in das Datenmanagement und die Datenanalytik unterteilen. Dabei umfasst das Datenmanagement die Erfassung, Aufzeichnung, Extraktion, Bereinigung, Notierung und Integration von Daten. Die Datenanalytik verarbeitet die Daten, umfasst die Durchführung von Analysen, das Anlegen von Modellen und die Nutzung dieser zur Entscheidungsfindung. Für die Durchführung eines Big-Data-Projektes in einem produzierenden Unternehmen existiert seit 2019 die VDI/VDE-3714-Richtlinie. Die darin dargestellten Phasen werden iterativ im Projekt durchlaufen. Bei der Durchführung eines Big-Data-Projektes müssen zunächst einige Voraussetzungen erfüllt werden, beispielsweise eine ausreichende Datenqualität. In der anschließenden Definitionsphase werden Fragen sowie Ziele präzisiert. Darauf aufbauend erfolgt eine Sondierung der Datenlage, gefolgt von der Datenbewirtschaftung. Hier werden zumeist verschiedene Datenquellen zusammengeführt. Aus den Daten wird nun in der Modellierungsphase ein auswertbares Modell generiert und dieses für die Datenanalyse genutzt. Nach einer Validierung des Modells kann eine erste Bewertung der Datenanalyse-Ergebnisse hinsichtlich der Projektziele vorgenommen werden. Als Bewertungsunterstützung kann hierbei auf die Visualisierung der Daten und Ergebnisse zurückgegriffen werden. Die vorletzte Phase widmet sich der Umsetzung und Einführung der Big-Data-Anwendung. Zum Abschluss wird gemäß der Richtlinie auf die nachhaltige Sicherstellung des erzielten Projekterfolgs eingegangen. Alternativ zur VDI/VDE-3714-Richtlinie können die etablierten organisatorischen Prozessmodelle KDD-Prozess, CRISP-DM oder SEMMA angewendet werden.

Was gilt es zu tun?

Dieser Beitrag beschreibt das Potential und einige Herausforderungen in Verbindung mit Big-Data-Projekten im Produktionsumfeld. Um einen Mehrwert aus großen Datenmengen generieren zu können, sind spezielle Kompetenzen erforderlich. Dieses Knowhow liegt bei KMU derzeit allerdings selten vor. Um sich zukünftig Wettbewerbsvorteile durch Big Data verschaffen zu können, sind KMU gefordert, ihre bestehenden Unternehmensstrukturen dahingehend anzupassen und Vorurteile gegenüber Big Data abzubauen.