Trotz zahlreicher Innovationsmöglichkeiten zögern viele Unternehmen und Behörden noch bei der Nutzung von künstlicher Intelligenz (KI) im Bereich Cybersicherheit. Ein wesentlicher Grund: Die Leistungsfähigkeit von Systemen ist oft nur schwer zu beurteilen. In einem Workshop am Fraunhofer-Institut für Sichere Informationstechnologie SIT haben Experten aus Wissenschaft und Wirtschaft Empfehlungen erarbeitet, wie Hindernisse für den KI-Einsatz überwunden werden können: Hierzu zählen konkrete Qualitätskriterien und Prüfmöglichkeiten.

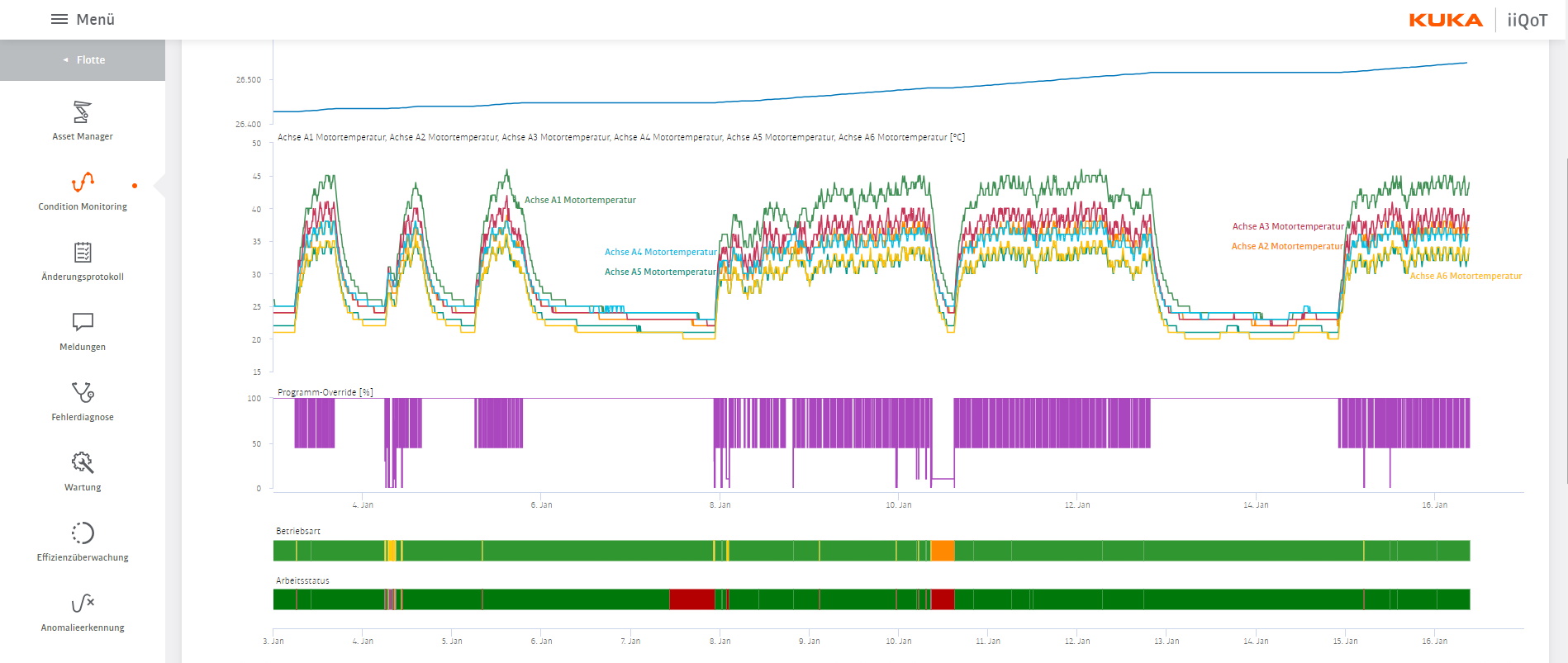

Die Cybersecurity-Branche gehört zu den Pionierinnen in der Anwendung der künstlichen Intelligenz. Sie wird seit Jahren in der Angriffserkennung und bei Virenscannern eingesetzt. Allerdings halten offene Fragen hinsichtlich Sicherheit, Datenschutz und Haftungsrisiken viele Unternehmen und Behörden von der praktischen KI-Nutzung ab. Oft fällt es Anwender-Organisationen schwer zu beurteilen, ob KI-Systeme überhaupt die notwendige Reife für die Praxis besitzen. Gleichzeitig können Hersteller-Unternehmen Sicherheit und Qualität ihrer KI-Produkte nur schwer nachweisen. In Laborumgebungen erkennen KI-Systeme zum Teil sehr gut Angriffsmuster, in realen Internetumgebungen allerdings nicht. Prüfpunkte und entsprechende Benchmarks können hier Anwenderorganisationen- und Herstellerunternehmen eine verlässliche Orientierung verschaffen. Spezifische Mindestanforderungen von Branchenverbänden können Orientierung schaffen und die öffentliche Hand könnte Testzentren unterhalten, welche die Einhaltung der Kriterien prüfen können, etwa für den Einsatz in kritischen Infrastrukturen.

Eine besondere Herausforderung stellt die Verwendung von KI-Systemen durch Angreifer und Saboteurinnen dar. Heute nutzen Unternehmen bereits KI-Systeme zum Schutz des Firmennetzwerks, um Angriffe schneller zu erkennen und zu vereiteln. Angreifende manipulieren die Trainingsdaten solcher Systeme oder nutzen auch selbst KI-Systeme als Angriffswaffen. So können Angreifende eine Firma wiederholt angreifen und das System dadurch besonders gut trainieren. Wechselt der Angreifende das Ziel und attackiert dann ein anderes Unternehmen, kann das trainierte System vielfach ausgeklügelter vorgehen. Um der Verwendung von KI als Angriffswaffe entgegenzuwirken, empfehlen die Teilnehmer des Eberbacher Gesprächs die Entwicklung eines nachprüfbaren Code of Conduct.

Interessierte können die Studie hier herunterladen.